OpenAI的Sora项目是一个基于Transformer架构的视频生成模型,旨在通过文本指令生成高清视频。该项目结合了扩散模型(Diffusion Model)和Transformer架构,以实现高效、高质量的视频生成。

Sora项目背景

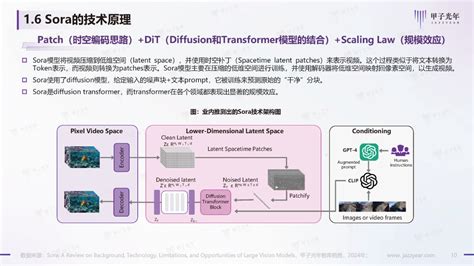

Sora是OpenAI于2023年2月发布的视频生成模型,能够根据用户提供的文本描述生成长达60秒的视频。这一模型的推出标志着AI技术在视频生成领域的重大突破,其核心在于将视觉数据转化为Patches,并利用Transformer架构进行处理。Sora的技术基础包括视觉理解、Transformers模型和大模型的涌现等。

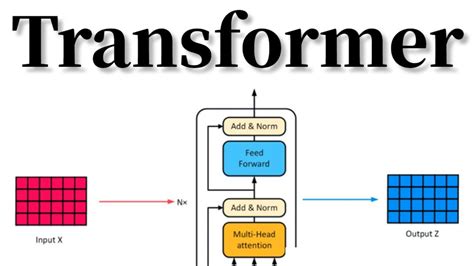

Transformer架构介绍

Transformer是一种革命性的神经网络架构,最初是为了改进机器翻译任务而设计的。它摒弃了传统的循环结构(如RNN和LSTM),采用编码器-解码器结构,并通过自注意力机制来捕捉输入序列内部的依赖关系。这种架构能够并行处理输入数据,从而加速训练过程并提高计算效率。

在Sora中,Transformer架构被应用于视频数据的处理,通过将视频分解为时空数据块(Patches),这些数据块类似于大语言模型中的tokens,用于训练模型。这种方法使得Sora能够同时处理时间和空间信息,从而更好地理解视频中的场景变换和主题一致性。

Sora的技术架构

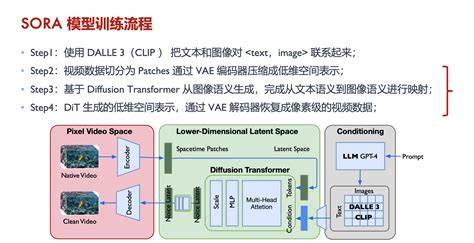

Sora的技术架构结合了扩散模型和Transformer的特点。具体来说,Sora采用了Diffusion Transformer(DiT)模型,该模型通过引入Transformer引擎来提升AI模型的规模和性能。在训练阶段,Sora使用Text Encoder将文本提示作为输入,通过Unet进行机器学习;在推理阶段,Unet根据用户输入的文本生成新的视频。

此外,Sora还采用了视频压缩网络,将原始视频压缩到低维的潜在空间,并在此空间内进行训练和生成视频。这种方法不仅提高了视频生成的质量,还增强了模型的扩展能力。

Sora的应用前景

Sora在多个领域具有广泛的应用潜力,包括电影、教育、游戏、医疗保健和机器人等。其生成的视频效果逼真、复杂,并且支持多镜头切换和风格修改,这使得Sora在内容创作和社交平台上有很大的应用前景。

Sora的成功展示了Transformer架构在视频生成领域的巨大潜力,同时也为未来AI技术的发展奠定了基础。

Copyright © 2013-2020 idc10000.net. All Rights Reserved. 一万网络 朗玥科技有限公司 版权所有 深圳市朗玥科技有限公司 粤ICP备07026347号

本网站的域名注册业务代理北京新网数码信息技术有限公司的产品